方法原理

算法总体流程

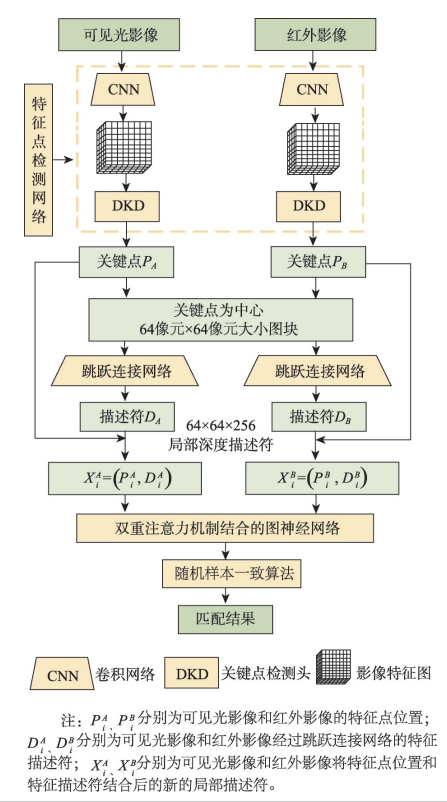

本文提出的融合跳跃连接网络与双重注意力机制的可见光与红外遥感影像匹配方法(CSDA-VIRSMatching)包括特征点检测模块、描述符构建模块和局部特征匹配模块,算法总体流程如下:

特征点检测

多尺度特征提取与可微分关键点检测

描述符构建

跳跃连接深度卷积网络生成256维特征描述符

特征匹配

双重注意力机制图神经网络实现准确匹配

误匹配剔除

RANSAC方法筛选最终匹配点对

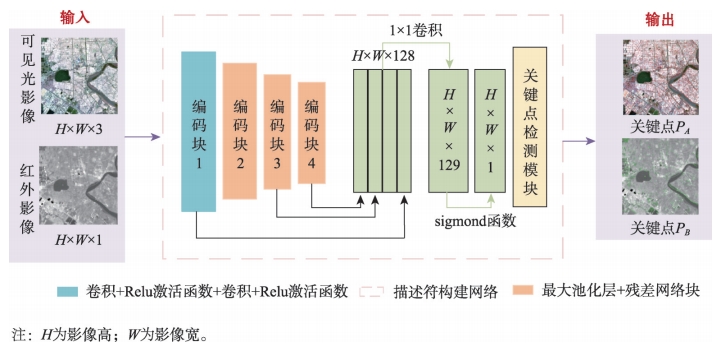

特征点检测网络

实现异源遥感影像的稳健匹配,准确的、有效性高的特征点提取是首要前提。特征点提取网络结构由特征编码器、特征聚合器、特征提取头、可微分关键点检测4个模块构成。

特征编码器

特征编码器包含4个编码块:第一个编码块是一个卷积块,由激活函数ReLU和2个3×3的卷积层组成,用于提取大小和原始输入图像一致的且特征通道为32维的特征图X1,这一尺度特征图感受野较小,提取的是相对底层的边缘、角点等局部特征。

第二、三、四编码块分别各由包含一个最大池化层和一个3×3卷积的基本残差块组成。随着网络层次的加深,图像上感受野变大,特征图X2、X3、X4可以更好表达图像的高层次语义信息和结构特征,有利于抵抗异源影像灰度差异带来的干扰,提高网络泛化能力。

特征聚合器

特征聚合器对特征X1、X2、X3、X4分别进行1×1的卷积操作,将不同维度特征的通道数统一为128维度。之后,再对特征X2、X3、X4进行双线性上采样操作,将三者的大小都恢复到原始图像大小。最后将4个特征图进行连接,通过一个1×1的卷积操作实现特征融合,得到最终的特征图X。特征聚合器将不同尺度、不同层次的图像特征信息相结合,在保留了图像高级语义信息的同时又恢复了图像的分辨率,保证了特征点的提取精度。

关键点检测模块

特征检测头用一个1×1的卷积操作对特征X的维度进行扩充,得到129维的影像特征图,之后对最后一维特征采用Sigmoid函数处理得到影像关键点得分图S ∈ RH × W × 1。

本文采用了一种部分可微分的关键点检测模块,使用softargmax方法从局部窗口中提取可微分的关键点。相比传统的非极大值抑制(NMS)方法,该方法是可微分的,能够利用深度学习的优势进行端到端训练,提高特征点检测的精度。

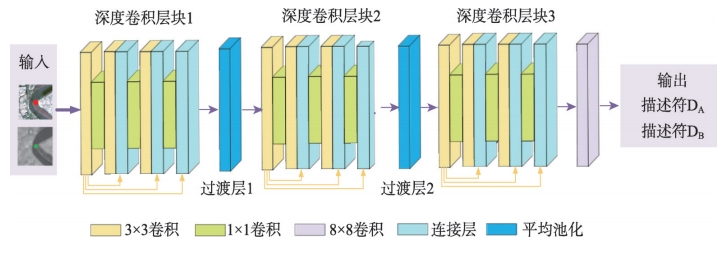

描述符构建模块

描述符构建模块采用跳跃连接的深度卷积神经网络,对以关键点为中心的64像素×64像素大小的图像块构建256维局部深度特征描述符。

跳跃连接网络的主要特点是在不同层之间建立直接连接,使得网络能够同时利用低层的细节特征和高层的语义特征,这对于异源影像匹配尤为重要。该网络结构具有以下优势:

- 通过多层网络结构学习到异源影像从简单到复杂的特征

- 跳跃连接保留了低层次的细节信息,有助于精确定位特征点

- 生成的256维描述符能更全面地捕捉并表达异源影像上的局部特征

- 弥补传统手工描述符无法表达异源影像在视觉差异的弱点

描述符构建模块首先将以关键点为中心的64×64图像块输入网络,经过多层卷积、池化和跳跃连接操作,最终输出256维的特征描述符。这些描述符包含了丰富的局部特征信息,为后续的特征匹配提供了可靠的基础。

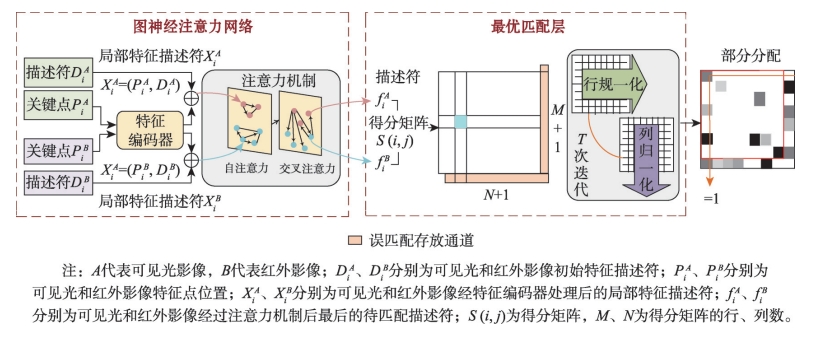

局部特征匹配模块

局部特征描述符匹配部分,使用融合自注意力与交叉注意力机制的图神经网络,通过综合考虑全局信息,精确调整每个匹配对的权重,减少误匹配的发生。

自注意力机制

自注意力机制使网络能够在单个图像内部进行深入特征分析,加强局部特征之间的联系和区分度。通过计算同一影像内不同特征点之间的相关性,突出重要特征,抑制不重要特征,提高特征表达的一致性。

交叉注意力机制

交叉注意力机制通过在两种模态影像间建立直接关联,减少不同成像特性给匹配带来的困难。它计算可见光影像和红外影像特征之间的相关性,找出最可能匹配的特征点对,有效应对异源影像之间的灰度差异和非线性辐射畸变。

融合自注意力和交叉注意力机制的图神经网络通过对全局信息的综合考虑,精确调整每个匹配对的权重,减少误匹配的发生,确保最终匹配结果准确性。具体步骤如下:

- 将影像特征点位置及对应描述符作为输入

- 经过多层感知机形成局部深度描述符

- 通过自注意力机制增强单一影像内部特征的一致性

- 通过交叉注意力机制建立两种影像特征之间的关联

- 生成匹配概率矩阵,确定最佳匹配点对

- 采用RANSAC方法进行误匹配剔除

这种双重注意力机制的设计使得网络能够同时考虑单一影像内部的特征关系和不同影像之间的特征对应关系,大大提高了异源影像匹配的准确性和鲁棒性,特别是在处理具有显著灰度差异和非线性辐射畸变的可见光与红外遥感影像时表现出色。