1 引言

遥感变化检测是一种通过对比不同时期的遥感影像,精准捕捉地表覆盖与土地利用变迁的技术。遥感变化检测技术从是否检测变化地物类别(即"从""到"信息)的角度可分为二值变化检测与语义变化检测(Semantic Change Detection,SCD)两大类。尽管二值变化检测能自动监测影像中的变化区域,但其提供的信息较为粗略,无法细化至具体的地物变化类型。相比之下,SCD不仅定位变化区域,还详尽提供变化前后的地物类别信息,对于深化人与自然相互作用的理解及推动可持续发展战略具有重要意义。

图1 不同语义变化检测框架

随着我国航天遥感技术不断发展,超高分辨率(Very-High-Resolution, VHR)遥感影像越来越容易获取,这为全球地表语义变化检测提供了丰富的数据资源。从VHR影像中获取精细的语义变化信息可持续动态观测地表变化,对于土地规划、城市管理和可持续发展具有重要应用价值。

近年来,深度学习技术迅猛发展,并被成功应用到遥感影像智能解译中,基于深度学习的SCD技术也成为当前的研究热点。SCD方法根据网络结构可分为3类:即分类后SCD、直接SCD、多任务SCD。

2 研究方法

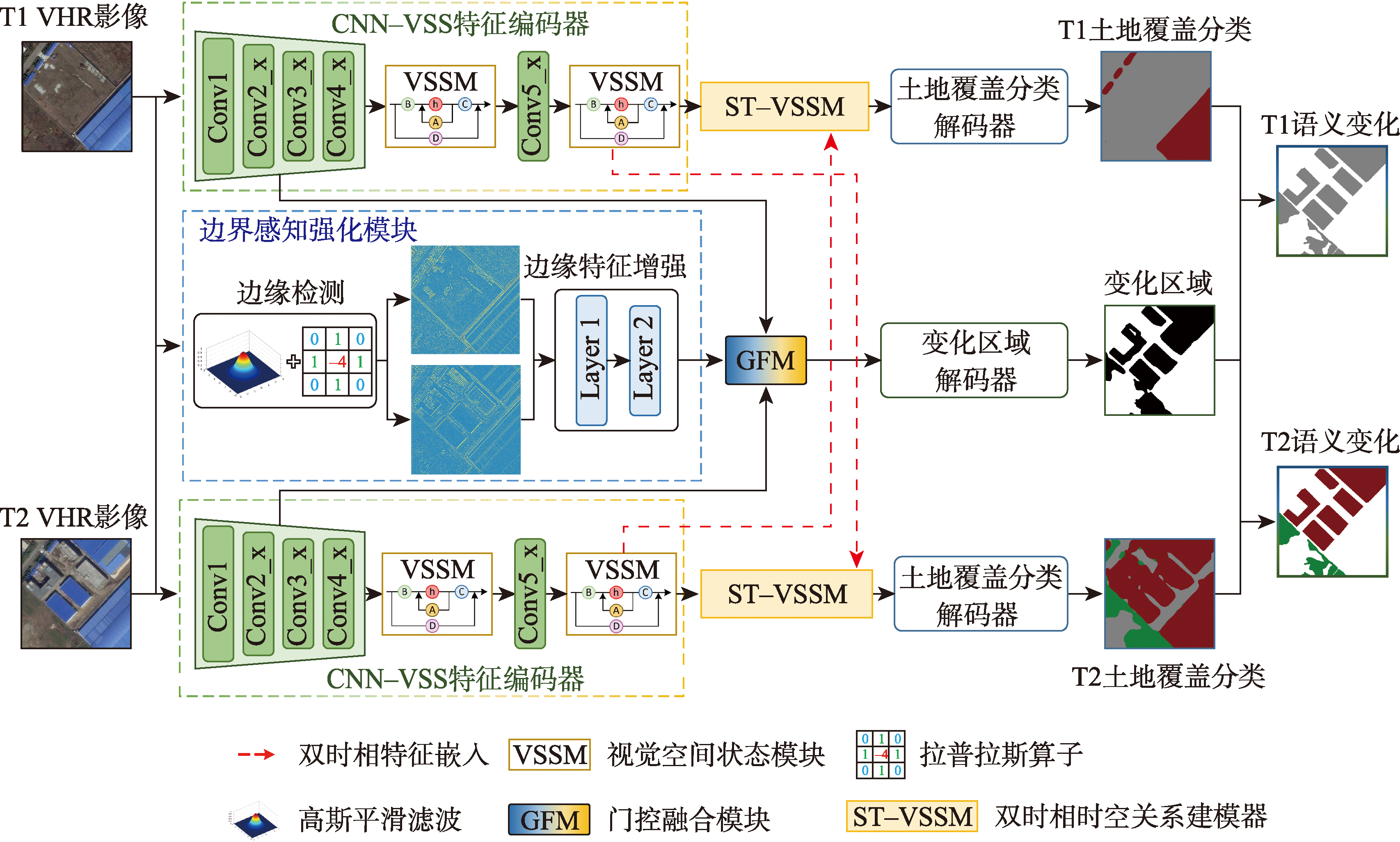

基于CVS-Net高分辨影像语义变化检测的总体流程如图2所示, CVS-Net遵循多任务SCD范式,同时执行土地覆盖分类和区域变化检测任务。在编码阶段,语义特征和边缘信息的提取被解耦为2条路径。双时相影像的多层级语义特征由孪生CNN-VSS特征编码器提取,而边缘感知强化分支(BAS)被用于提取边缘信息。为挖掘深层次的双时相语义特征间的时空关联,使用时空关系建模器(ST-VSSM)重塑双时相语义特征。之后,将融合后的多层级语义特征和边缘特征输入变化区域解码器,获取变化区域结果。双时相土地覆盖分类结果由土地覆盖分类解码器获取。最后,将分类结果映射到变化区域,生成双时相SCD结果。

图2 基于CVS-Net的语义变化检测流程

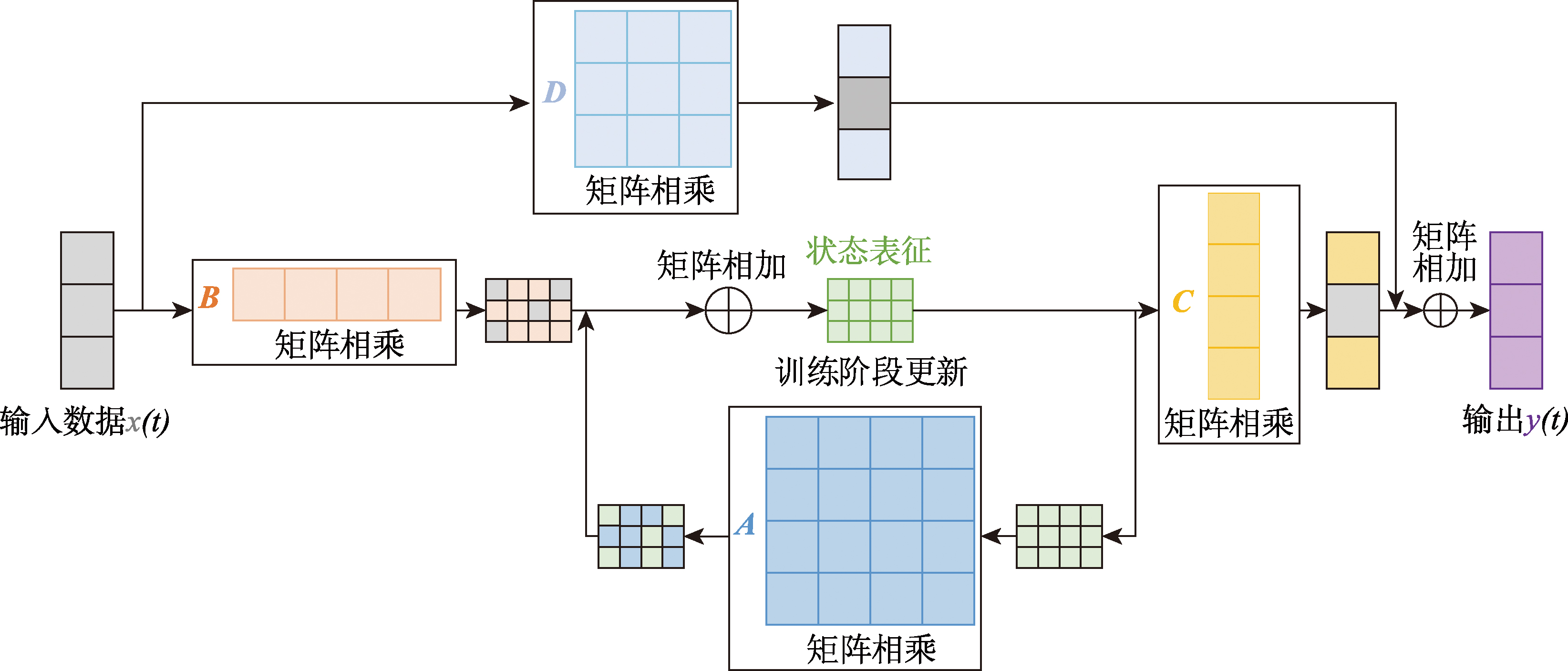

2.1 状态空间模型原理

SSM是一种描述动态系统行为的数学模型,其使用一组一阶微分方程(连续时间系统)或差分方程(离散时间系统)表示系统的内部状态演化:

h'(t)=Ah(t)+Bx(t)

同时,用另一组方程来描述系统状态和输出之间的关系:

y(t)=Ch(t)+Dx(t)

图3 状态空间模块(SSM)特征传播过程

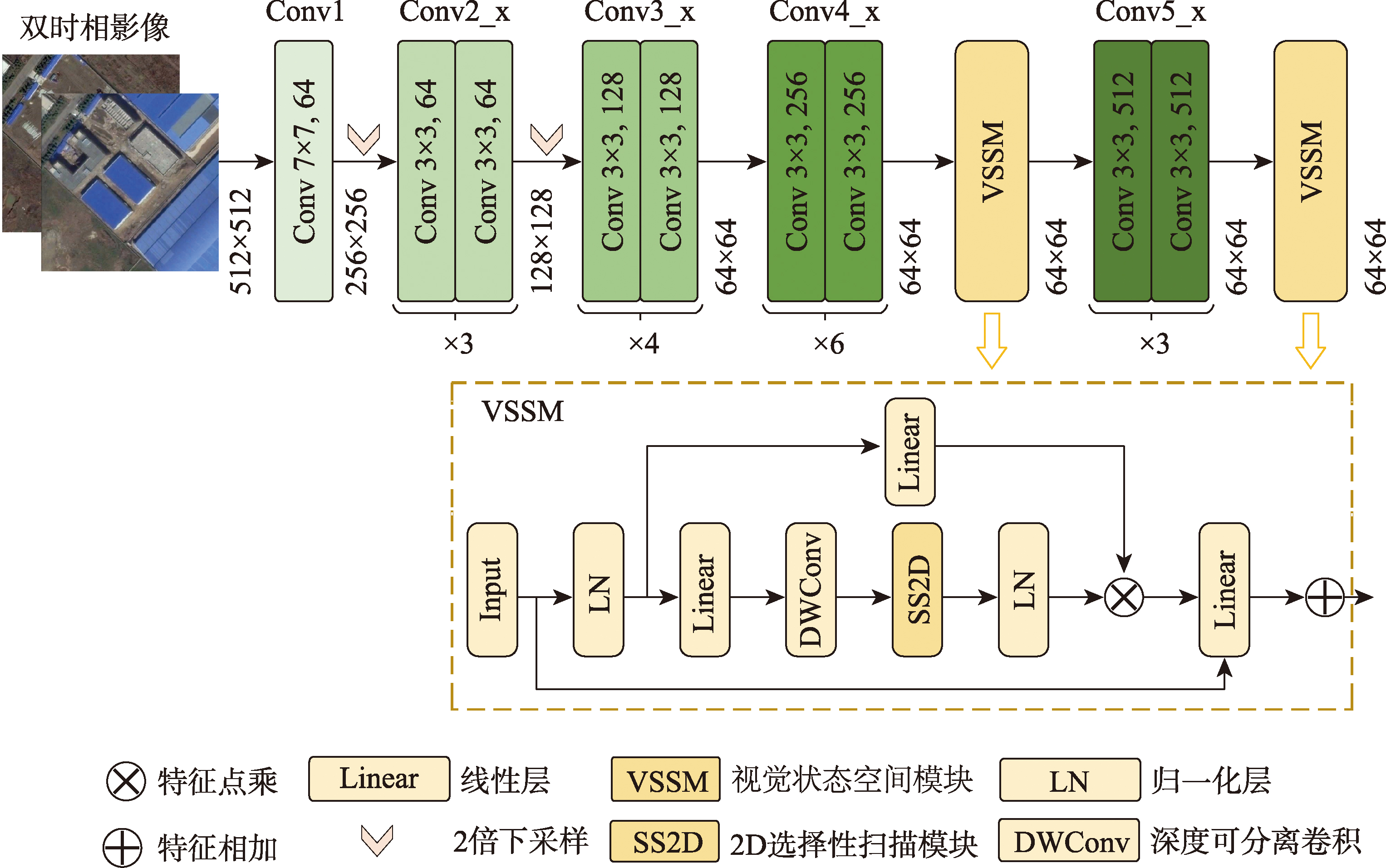

2.2 CNN-VSS特征编码器

本文结合CNN和VSSM构建孪生特征编码器CNN-VSS,旨在同时提升变化检测网络的局部和全局特征提取能力。如图4所示,CNN-VSS由一个改进的ResNet34网络和一个视觉状态空间模块构成。

图4 结合ResNet34和状态空间模块的CNN-VSS特征编码器网络结构

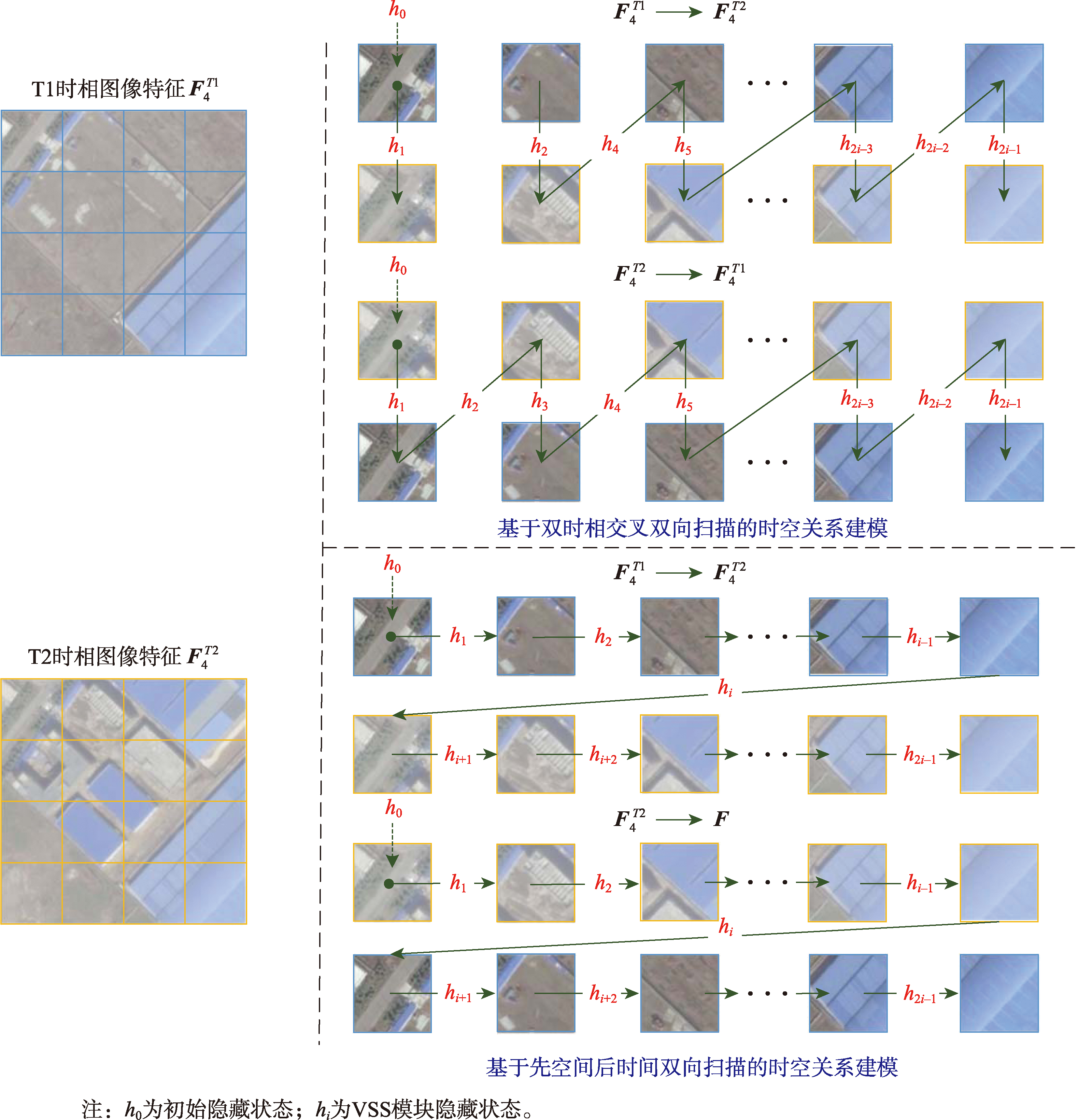

2.3 双时相时空关系建模器

为充分挖掘双时相影像的时空联系,引导网络学习影像间的时空变化逻辑,本文构建了一种基于VSSM的双时相时空关系建模器(ST-VSSM),如图5所示。受视觉Mamba的扫描方式启发,本文提出的双时相扫描策略包含2种扫描方式,分别是基于双时相交叉扫描和先空间后时间扫描。

图5 双时相时空特征建模器流程

2.4 边缘感知强化分支

边缘感知强化分支(BAS)由基于拉普拉斯算子的边缘检测和边缘特征增强模块构成,结构细节如图6所示。首先,使用高斯平滑滤波器来降低图像噪声敏感性;随后,使用3×3的拉普拉斯算子生成初始边缘特征BL0。

图6 基于拉普拉斯的边缘感知强化分支

2.5 联合损失函数

CVS-Net由4个损失函数联合训练,其中采用多类交叉熵损失函数Ls训练语义分类任务;使用DiceLoss函数LR训练变化区域检测任务;采用变化语义一致性损失函数Lsc保证语义信息和变化信息的一致性。联合损失函数Lscd的计算公式为:

Lscd=w1⋅Ls1+w2⋅Ls2+w3⋅LR+w4⋅Lsc

3 实验设计与结果分析

3.1 实验数据与实验细节

在SECOND数据集和福州数据集(FZ-SCD)上开展验证实验。SECOND是语义变化检测的一个主流公开数据集,涵盖多种城市场景以及常见的变化类型。其包含了从多个平台和传感器收集的4 662对航空图像,图像对主要分布在杭州、成都和上海等城市。每个图像的尺寸为512像素×512像素,包括6种主要的土地覆盖类别,即非植被地表、树木、低矮植被、水体、建筑物和娱乐设施。本文按照7∶2∶1比例划分训练集、验证集和测试集。

图7 FZ-SCD数据集影像及语义变化标签

表1 FZ-SCD数据集中五种地物的判读标准

| 类别 | 定义 |

|---|---|

| 裸地 | 目前还未利用的土地,包括难利用的土地。在GF-2影像中裸地的反射率高,植被覆盖度低(在5%以下),纹理均一,容易同沙地和灰白色的建筑混淆 |

| 建筑 | 建筑是指供人在内居住、工作、学习、娱乐、储藏物品或进行其他活动的空间场所,尤其是指房屋 |

| 植被 | 遥感影像上植被不是以个体的形态表现,而是群体的分布范围,包括草地、林地等。由于植被类型、疏密程度、生长状况等不同,在图像上往往形成色调差异。因此,在判读时主要可根据植物的光谱特性和影响植物光谱的各种因素作综合判读 |

| 水体 | 天然陆地水域和水利设施用地 |

| 道路 | 包含铁路、公路、乡村大路和小路,道路的形状在像片上可以根据路面宽度、色调和形状进行判读;在标注道路时,要求沿道路边沿进行标注,不包含绿化带 |

3.2 SECOND数据集上的实验结果对比分析

在SECOND数据集上,CVS-Net方法与其他7种主流SCD方法的实验结果如表2所示。CVS-Net取得了最佳的SCD结果,在6个关键指标上均超越了其他方法,误检率、mIoU、Fscd和SeK分别达到30.79%、72.89%、63.39%和和23.95%。

表2 不同SCD模型在SECOND数据集上的精度评价结果 (%)

| 方法 | 漏检率 | 误检率 | OA | mIoU | Fscd | SeK |

|---|---|---|---|---|---|---|

| HRSCD.str4 | 31.50 | 35.21 | 85.20 | 70.88 | 58.61 | 19.17 |

| Bi-SRNet | 24.85 | 34.91 | 86.13 | 71.91 | 61.51 | 21.96 |

| ChangeMamba | 24.39 | 32.87 | 86.98 | 72.68 | 62.23 | 22.49 |

| SCanNet | 23.94 | 31.85 | 87.14 | 72.77 | 62.86 | 23.13 |

| TED | 27.12 | 34.26 | 85.70 | 71.07 | 61.68 | 21.77 |

| SMNet | - | - | 86.68 | 71.95 | 60.34 | 20.29 |

| MTSCD-Net | - | - | 87.04 | 71.68 | - | 20.57 |

| CVS-Net(本方法) | 23.31 | 30.79 | 87.20 | 72.89 | 63.39 | 23.95 |

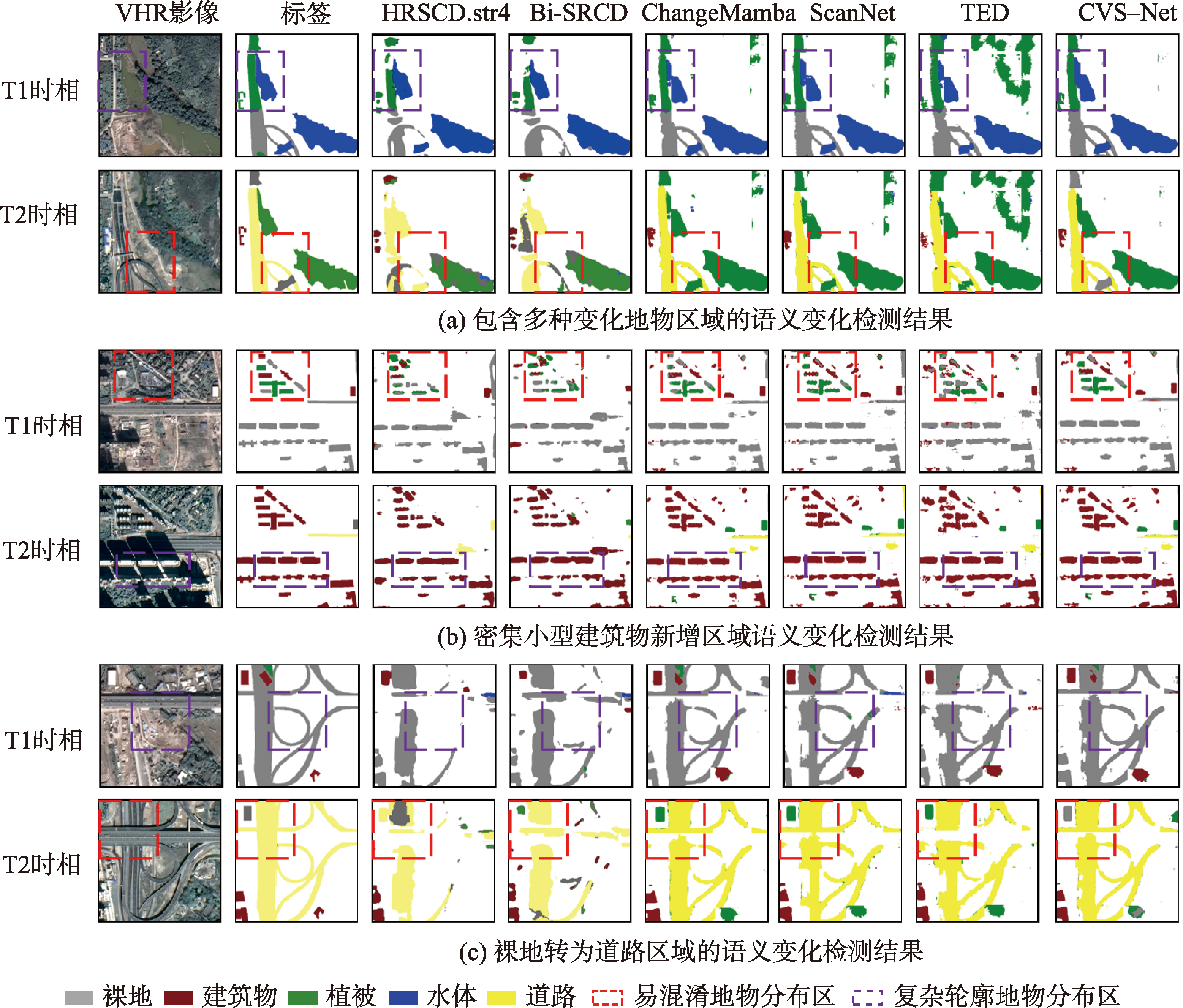

图8 不同方法在SECOND数据集上的SCD结果

3.3 FZ-SCD数据集上的实验结果对比分析

表3列出了各方法在FZ-SCD数据集上的精度评价结果,其中本文方法CVS-Net在所有精度指标上均取得了最佳结果,漏检率、误检率、OA、mIoU、SeK和FSCD分别为25.74%、33.27%、87.11%、72.60%、23.02%和62.56%。

表3 各方法在FZ-SCD数据集上的SCD结果精度评价 (%)

| 方法 | 漏检率 | 误检率 | OA | mIoU | Fscd | SeK |

|---|---|---|---|---|---|---|

| HRSCD.str4 | 31.50 | 35.21 | 84.22 | 69.30 | 55.63 | 16.25 |

| Bi-SRNet | 27.89 | 33.96 | 86.54 | 72.02 | 61.45 | 21.87 |

| ChangeMamba | 26.39 | 33.87 | 86.62 | 72.17 | 61.32 | 22.34 |

| ScanNet | 26.03 | 33.71 | 86.93 | 72.43 | 61.90 | 22.89 |

| TED | 26.98 | 34.91 | 86.57 | 71.91 | 61.99 | 22.08 |

| CVS-Net(本方法) | 25.74 | 33.27 | 87.11 | 72.60 | 62.56 | 23.02 |

图9 不同方法在FZ-SCD数据集上的SCD结果

4 结论与讨论

4.1 结论

本文提出了一种结合卷积神经网络和视觉状态空间原理的SCD网络CVS-Net。CVS-Net有效地融合了CNN在局部特征提取方面的优势与VSSM在捕捉长距离依赖关系上的能力,实现了两者优势的互补。其次,本文构建了一种基于VSSM的双时相时空关系建模器(ST-SS2D),用以引导网络学习影像间的时空变化逻辑,提升变化区域的语义分割精度。最后,为了进一步提升模型对变化对象边缘的识别精度,在CVS-Net中引入了边缘感知强化分支,该分支通过精细的边缘信息增强,显著提升了模型对变化区域边缘的识别能力。在SECOND和FZ-SCD数据集上进行实验,结果表明:

- 相比主流的SCD方法,如HRSCD.str4、Bi-SRNet、ChangeMamba、ScanNet和TED,本文方法CVS-Net在SECOND与FZ-SCD 2个数据集上均展现了最优的检测性能,有效提升了语义变化检测的整体精度。CVS-Net显著减少了漏检情况,mIoU分别达到72.89%和72.60%,且变化语义识别精度得到明显提升,在2个数据集上的SeK指标平均提高了2.75%和1.93%。这些结果有力地验证了本方法的有效性。

- CNN-VSS特征提取器较基于CNN、Transformer和Mamba的特征提取器的SCD结果,有效提升了变化区域检测和语义类别识别精度, mIoU最高提升了1.68%,Fscd最高提升了1.71%。此外,CNN-VSS在提升特征表征能力的同时兼顾了模型复杂度,其参数量仅为22.05 Mb。ST-SS2D可有效建模变化地物的双向时空联系,从而增强了模型对于潜在地物变化逻辑的挖掘能力,其SeK值相比于STM_1、STM_2和STM_3方法,分别提升了1.23%、0.82%和1.52%。

- 本方法获取的变化区域与实际变化区域的一致性程度最高,一致性程度评价指标Ḉ达到92.97%,且变化区域的边缘更加精准,特别是在形状不规则的变化区域。

4.2 讨论

本方法通过联合CNN和VSSM的特征提取优势构建混合特征编码器,与现有的基于CNN和基于VSSM的SCD方法相比,具有更全面的局部和全局特征提取能力。提出的基于VSSM的双向时空依赖关系建模方法,强化了模型对于变化模式的判别能力,提升了变化检测精度。但是,基于CNN和VSSM的特征提取方法,均会在相邻像素之间引入空间不连续性,且忽视了大尺度地物的完整性,阻碍了序列中的有效信息流。在后续工作中,将重点改进VSSM的特征扫描方法,以克服现有特征提取机制缺陷。此外,现有的SCD数据集样本较少,且样本包含的语义类别较多,导致SCD精度提升受限。后续计划研究SCD样本扩增和半监督SCD方法,降低深度网络对于样本数量的依赖,提升语义分割算法的实用能力。

* 以上内容由AI自动生成,内容仅供参考。对于因使用本网站以上内容产生的相关后果,本网站不承担任何商业和法律责任。